Realidad aumentada

Realidad aumentada: componente habilitador para una integración constructiva virtual en vivo efectiva

Autores:

Frank Dean - Investigador principal

Centro de tecnología de simulación y entrenamiento, RDECOM del ejército de EE. UU.

12423 Research Parkway

Orlando, FL 32826-3276

Frank.Dean@us.army.mil

Sheila Jaszlics - Presidenta

Richard Stilson - Ingeniero

Scot Sanders - Ingeniero

Pathfinder Systems, Inc.

5525 West 56th Ave, Suite 400

Arvada, CO 80002-2804

sheila@snakephotographer.com

rstilson@snakephotographer.com

ssanders@snakephotographer.com

Abstracto

Este artículo describe los resultados de un proyecto de investigación RDECOM llamado Sistema de entrenamiento de realidad aumentada desmontado (DARTS). El prototipo DARTS que se desarrolló bajo este esfuerzo proporciona datos alentadores y la confianza de que las herramientas y técnicas que son necesarias para implementar esta tecnología, en un entorno de entrenamiento militar en vivo, no están lejos. En última instancia, la clave para la implementación y el uso exitosos de esta tecnología emergente es que los entrenadores comprendan sus usos potenciales y pongan el énfasis de mando en un mayor desarrollo para usos militares específicos.

Introducción

Imagine que el Warfighter tiene una capacidad incorporada eficaz para entrenar en cualquier lugar y en cualquier momento sin la necesidad de una preparación prolongada. Dada la cantidad de tiempo y recursos fiscales invertidos en varios tipos de sistemas de entrenamiento militar, una de las formas más eficientes de alcanzar ese objetivo sería fusionar los sistemas existentes y planificados en un entorno integrado más amplio. En otras palabras, difumine las líneas o límites, tanto física como mentalmente, que separan el entrenamiento del Warfighter en los entornos de entrenamiento discretos en vivo, virtuales y constructivos que usamos hoy.

Con tal capacidad, los capacitadores pueden combinar o conectar los sistemas apropiados y disponibles para cumplir con los objetivos de capacitación apropiados. En esta línea, una de las principales áreas de interés de la comunidad de entrenamiento del Ejército es implementar la integración en vivo, virtual y constructiva. Desafortunadamente, a partir del prospecto actual de LVC-IA, no hay un flujo bidireccional y una presentación de datos de entrenamiento entre el dominio de entrenamiento en vivo y los dominios de entrenamiento virtual-constructivo. Los esfuerzos en curso de investigación y adquisición de LVC se centran principalmente en la transmisión de los datos de posición de los participantes en vivo al dominio virtual para su visualización e interacción. Sin embargo, los participantes en vivo no pueden "ver" la representación en tiempo real de personal, vehículos, fuego y efectos, etc. que se originan en el dominio virtual. Con el fin de "entrenar la fuerza, cómo y mientras lucha" de manera eficaz debe haber una réplica completa de entornos operativos complejos. Para obtener una imagen más real de los entornos operativos complejos, debe haber una integración completa: una vía de dos vías para el flujo de datos a través de los dominios de capacitación. Si el flujo de datos e información es solo en una dirección, entonces la arquitectura no está ni puede declararse "completamente integrada".

Siendo el nuevo paradigma de transformación en la formación, ¿cómo sería un entorno de formación complejo integrado de LVC? Imagine el siguiente escenario:

Los miembros de una pequeña unidad participan en un ejercicio de entrenamiento en vivo en Ft. Lewis, WA o Ft. Hood, TX. Durante el ejercicio hay una convocatoria de apoyo aéreo cercano, que es proporcionado por un piloto que se está entrenando en un entrenador de armas combinadas de aviación, ubicado en Ft. Rucker, AL o Ft. Bragg, Carolina del Norte. En el acercamiento para brindar apoyo aéreo cercano, los monitores del piloto brindan una vista integrada del espacio de batalla, incluidos íconos / avatares que representan las posiciones rastreadas de los miembros de la unidad pequeña. Mientras opera en el entorno virtual, el piloto puede ver los miembros de la unidad pequeña; sin embargo, la pequeña unidad que opera en el entorno en vivo no puede ver ni reaccionar a las acciones del piloto, sin alguna intervención de quizás un observador-controlador (OC). Un entorno complejo verdaderamente integrado permitiría a la pequeña unidad que está operando en tierra al menos observar la aeronave y cualquier incendio y efectos resultantes de la misión del piloto. Actualmente eso no sucede. ¿Qué tecnologías se pueden desarrollar y aplicar para proporcionar un entorno de formación integrado más eficazmente y capacidad para este y otros escenarios similares? ¿Existe una solución disponible que permita a un Warfighter montado o desmontado, que está operando en el entorno en vivo, "ver" e "interactuar" con aquellos que están operando de manera virtual o constructiva? ¡La respuesta es sí!" La solución es la realidad aumentada.

Arquitectura integrada constructiva virtual en vivo (LVC-IA)

(Información extraída del Project Manager de Future Force (simulación))

Concepto LVC-IA

El LVC-IA integra sistemas de simulación en vivo, virtuales y constructivos actuales y futuros con el fin de estimular los sistemas de comando de batalla para la planificación, ensayo y entrenamiento de misiones. Por lo tanto, LVC-IA proporciona un entorno de entrenamiento LVC integrado que amplía el espacio de batalla disponible, al tiempo que permite que el entorno de entrenamiento se aproxime más al entorno operativo. Un entorno LVC integrado permite la planificación de misiones distribuidas bajo demanda, los ensayos y la capacitación que se requieren para ganar y mantener el dominio de las habilidades en la conciencia del espacio de batalla, la aplicación de la fuerza, la logística enfocada y la protección.

Plan LVC-IA

Implemente un conjunto estandarizado de protocolos, especificaciones y estándares que permitan la interoperabilidad y la integración entre los componentes de LVC del Ejército y del Conjunto.

Proporcione un entorno LVC integrado que garantice la compatibilidad e interoperabilidad de todos los TADSS y se integre completamente en el Sistema de Comando de Batalla de la Fuerza Futura, mientras se vincula y estimula los sistemas de Comando y Control Conjunto (JC2).

Proporcione la capacidad Plug-and-Train para respaldar las operaciones, la planificación y el ensayo de la misión, a pedido, en cualquier momento y en cualquier lugar, mientras se entrena en un contexto conjunto.

Permite la interoperabilidad y la integración entre: a. Familia conjunta de simulaciones (JFOM) y (Esfuerzos de JNTC). B. Arquitectura de instrumentación de formación común (CTIA). C. Núcleo de entorno sintético (SE). D. Federación de Entrenamiento Constructivo del Ejército (ACTF). mi. Arquitectura habilitadora de pruebas y formación (TENA). F. Otros componentes potenciales de LVC (FCS FoS, WIN-T?). gramo. Se incrusta y estimula JC2.

Realidad aumentada

¿Qué es la realidad aumentada (RA)? Las técnicas de RA mejoran la vista en vivo del Warfighter del complejo entorno de entrenamiento, proporcionando texto, gráficos, objetos 2D / 3D y otra información en tiempo real. Por lo tanto, AR proporciona al Warfighter, que opera en el entorno en vivo, una mayor conciencia de los impactos de las simulaciones de entrenamiento virtual y constructivo superpuestas. Este medio computacionalmente intensivo de fusionar entidades virtuales y en vivo en una vista perfectamente integrada del espacio de batalla puede proporcionar a los comandantes y entrenadores la capacidad de mezclar misiones de entrenamiento constructivas virtuales en vivo, así como coordinar e integrar varios efectos de entrenamiento en diferentes entornos. Si se usa de manera apropiada, la RA puede aumentar el realismo y la efectividad del entrenamiento en vivo, tanto desde prospectos montados como desmontados, mientras se fusiona con los dominios de entrenamiento virtual y constructivo.

Aunque en la actualidad el Ejército de los EE. UU. No tiene un requisito definitivo para el uso de la Realidad Aumentada, una investigación reciente realizada en el Centro de Tecnología de Simulación y Capacitación (STTC), Comando de Investigación, Desarrollo e Ingeniería (RDECOM), Orlando, Florida sugiere que La realidad aumentada se puede utilizar en una amplia variedad de aplicaciones de entrenamiento del ejército. El concepto de entornos en vivo aumentados tiene el potencial de crear entornos interactivos, multisensoriales y no lineales que brindan al Warfighter un entrenamiento en vivo y un aprendizaje experiencial incomparables y realistas. Tal capacidad potencialmente proporcionaría a los comandantes y entrenadores conjuntos de soluciones creativas y flexibles para las misiones y los requisitos de entrenamiento siempre cambiantes y fluctuantes del Warfighter moderno.

¿Cuáles son los desafíos tecnológicos para proporcionar capacidades de realidad aumentada al Warfighter? Esta pregunta se responde mejor examinando algunas investigaciones recientes. El Sistema de Entrenamiento de Realidad Aumentada Desmontado (DARTS) es un proyecto financiado por RDECOM del Ejército de EE. UU. Que buscaba investigar problemas de tecnología de RA. El DARTS se inició originalmente en el marco del objetivo de tecnología integrada de soldados desmontados, ciencia y tecnología (ETDS STO), que finalizó en el otoño de 2004. El trabajo adicional del DARTS se financió y continuó en el marco de la capacitación del equipo de armas combinadas integradas, el objetivo de tecnología del ejército (ECATT ATO) y culminó con una demostración de tecnología en diciembre de 2005.

A pesar de los fondos limitados, Pathfinder Systems, Inc se ha enfrentado a un problema difícil, implementando Realidad Aumentada en tiempo real, sin ataduras y portátil, y ha diseñado un prototipo de desarrollo, que se demostró en diciembre de 2005. Aunque las restricciones de financiamiento se han retrasado trabajo adicional en esta área, se identificaron una serie de cuestiones e información valiosa para futuros análisis e investigaciones. El resto de este artículo describe los resultados de esta investigación.

Sistema de entrenamiento de realidad aumentada desmontado (DARTS)

El objetivo del esfuerzo de DARTS fue demostrar que es posible desarrollar un sistema de Realidad Aumentada (AR) que funcione en tiempo real, utilizando un conjunto de equipos compacto y no intrusivo usado por un guerrero. Nuestro objetivo era hacer que nuestro sistema de RA funcionara en un entorno que no fuera inspeccionado previamente, instrumentado o preparado de otra manera con anticipación para operar. Los sistemas AR anteriores no podían operar en tiempo real o requerían el uso de una infraestructura no móvil extensa. Muchos sistemas de RA requieren el uso de una compleja cuadrícula de puntos marcadores premedidos para funcionar. Claramente, la RA que requiere un preprocesamiento tan significativo del entorno no es la solución tecnológica más deseable para las aplicaciones de entrenamiento militar de ritmo rápido, en vivo o integradas.

El objetivo del sistema DARTS AR era insertar objetos virtuales (en este caso, un vehículo de combate de infantería virtual o ICV) en el campo de visión de un usuario mediante una pantalla transparente montada en la cabeza (HMD). El objeto virtual debe colocarse en el campo de visión del usuario para que parezca un objeto real con una ubicación física en el mundo real. Dado que el objeto virtual es en realidad solo una proyección en el HMD, la posición mostrada del objeto virtual debe moverse a medida que el usuario mueve la cabeza, de modo que el objeto virtual parezca estar fijo en una ubicación real. El usuario debe poder caminar hacia el ICV y verlo crecer a medida que se acerca. Asimismo, el usuario debe poder caminar alrededor del ICV y ver su parte frontal, posterior o laterales desde diferentes ángulos. Finalmente, si un objeto real, como un arbusto u otra persona, se interpone entre el usuario de AR y el tanque, la parte del ICV que estaría bloqueada de la vista no debería mostrarse. Todos estos objetivos se han logrado hasta cierto punto mediante esfuerzos de investigación de RA anteriores, pero no se han realizado en tiempo real, utilizando un sistema usado por el hombre, operando en un entorno no preparado.

En nuestro esfuerzo, también necesitábamos demostrar la capacidad de insertar contenido AR útil en el campo de visión de un usuario, de una manera que pueda contribuir al entrenamiento y operaciones militares. Esto podría incluir la visualización de datos de conciencia de la situación en forma de contornos de objetos o iconos de marcadores. También puede permitir que un usuario del sistema AR participe en una simulación, de modo que las unidades de un ejercicio de entrenamiento de simulación se muestren como objetos virtuales con los que el usuario puede interactuar. Establecimos un conjunto de requisitos para el esfuerzo base con estos objetivos generales en mente. Los objetivos específicos de este esfuerzo básico fueron:

Inyecte entidades virtuales en una escena en tiempo real del mundo real

Acomodar objetos del mundo real que bloquean la vista de un objeto virtual

Integre un vehículo de combate de infantería (ICV) simulado en la vista del usuario

Demostrar una interfaz de protocolo de simulación interactiva distribuida (DIS) bidireccional con el banco de pruebas de vehículos de combate de infantería RDECOM del ejército de EE. UU.

Demostrar la capacidad de operar un sistema AR sin ataduras usado por el hombre

Estos objetivos se presentan gráficamente a continuación:

Logros del programa DARTS

Nuestra demostración DARTS, realizada en diciembre de 2005, fue un éxito. Pudimos demostrar un sistema AR usado por el hombre que permitió a un usuario de DARTS interactuar con un ICV virtual que se presentó en el DARTS HMD. El usuario pudo ver el ICV virtual en el entorno del mundo real y en tiempo real desde diferentes puntos de vista. El usuario de DARTS también pudo ver el movimiento de ICV virtual en el entorno del mundo real y en tiempo real. A continuación, se resume un resumen de los componentes que nos ayudaron a realizar este logro:

Interfaz DIS bidireccional: Desarrollamos software para recibir y decodificar unidades de datos de protocolo DIS (PDU) desde una conexión de red, y también para codificar y enviar PDU DIS. Desarrollamos un código para convertir la posición y orientación de la entidad entre el marco de coordenadas mundial utilizado por el banco de pruebas ICV en un marco de coordenadas local utilizado por DARTS.

Control de entidad virtual: Integramos nuestro software de comunicación DIS PDU en DARTS para poder usar las coordenadas de posición y orientación de una PDU entrante para determinar la posición de un objeto virtual con respecto a la entidad DARTS. También desarrollamos código para convertir la posición local de la entidad DARTS en coordenadas mundiales y enviar esas coordenadas en una PDU DIS saliente. Desarrollamos y demostramos una interfaz DIS inicial con el simulador ICV que permitía que las entidades virtuales y en vivo interactuaran entre sí y permitía que un usuario desmontado viera una entidad virtual en una vista del mundo real en tiempo real.

Seguimiento de posición inalámbrico: Desarrollamos un software para acceder al sistema de seguimiento de posición inalámbrico Ubisense y obtener actualizaciones de posición varias veces por segundo. Estos datos de posición se utilizan para permitir que el sistema DARTS determine dónde se encuentra en relación con el mundo, de modo que podamos determinar cómo se debe mostrar una entidad virtual en el sistema DARTS y cómo se debe mostrar el usuario de DARTS en el mundo virtual de aparece el banco de pruebas ICV. Esta capacidad se utilizó para permitir demostraciones tempranas, a medida que desarrollamos nuestro seguimiento de puntos objetivos y algoritmos de recuperación de planteamientos que no requerirán el uso de ninguna infraestructura adicional más allá del equipo que usa el soldado. Estos nuevos algoritmos de recuperación de pose eventualmente reemplazarán los datos de posicionamiento proporcionados por el sistema UbiSense (a medida que haya fondos disponibles para continuar esta investigación). El sistema UbiSense también se utiliza para las pruebas del sistema DARTS para validar la precisión de nuestros algoritmos de recuperación de pose.

HMD basado en OLED: Integramos un HMD monocular con base OLED en el sistema para verificar la utilidad de las pantallas OLED para admitir el entrenamiento desmontado. El HMD proporcionó una fidelidad adecuada en una pantalla monocular. Pudimos trabajar con fabricantes de HMD basados en OLED como Liteye e ICUITI para desarrollar un diseño conceptual para un sistema binocular. En este momento, la tecnología OLED presenta el mejor potencial para el desarrollo de soluciones HMD que sean suficientes para soportar el entrenamiento desmontado y lo suficientemente económicas como para ser compradas en las grandes cantidades que serían necesarias si esta tecnología de entrenamiento fuera adoptada por el Ejército de los EE. UU.

Sistema de transmisión de TV inalámbrico para soporte de demostración: Evaluamos varios sistemas de transmisión de imágenes e implementamos varios sistemas opcionales para que la vista producida para el usuario de DARTS esté disponible para otros observadores cercanos.

Desarrollo de algoritmos de seguimiento de puntos y recuperación de pose: implementamos un algoritmo de seguimiento de puntos utilizando el entorno de software MATLAB que puede rastrear puntos a través de una serie de imágenes. Este algoritmo encuentra puntos de diferentes áreas de la imagen de video, utilizando un algoritmo que identifica puntos fáciles de rastrear. Una vez que el algoritmo identifica estos puntos fáciles de rastrear, busca una coincidencia para cada uno de estos puntos en imágenes sucesivas. Estos puntos se utilizan para determinar la posición y orientación del usuario de DARTS en relación con objetos del mundo real y entidades virtuales en el entorno. Esperábamos integrar el algoritmo mejorado en esta fase, pero no pudimos hacerlo debido al nivel de esfuerzo que tomó crear el algoritmo. Sin embargo, pudimos demostrar y validar el algoritmo utilizando videoclips obtenidos del sitio de demostración de STTC. Los siguientes párrafos proporcionan una descripción general del algoritmo de seguimiento de pose desarrollado para este esfuerzo.

Para mostrar un objeto virtual de modo que se superponga correctamente al mundo real, necesitamos tener una estimación muy precisa de la dirección en la que apunta el casco. Necesitamos rastrear esto de un momento a otro a medida que el usuario de DARTS se mueve, y hacerlo con la mayor precisión posible. Si la cabeza del usuario no se rastrea con precisión mientras se mueve, entonces el objeto virtual parecerá moverse contra el mundo real de una manera poco realista. Además, se pueden acumular pequeños errores de posición hasta que el sistema se pierda por completo. Por ejemplo, si un objeto virtual debe estar exactamente 10 metros al sur de la posición del usuario, entonces ese objeto debe estar centrado en el campo de visión del usuario si el usuario mira hacia el sur. Si el sistema pierde el seguimiento de la orientación del usuario, entonces no podrá mostrar el objeto cuando el usuario mire en la dirección correcta. En su lugar, podría mostrar el objeto al este o al oeste. Incluso podría hacer que parezca que el objeto virtual gira alrededor del usuario.

Para nuestro esfuerzo básico, usamos un sensor de posición inalámbrico y un sensor de posición inercial para rastrear la posición y orientación del casco DARTS. Estos sensores proporcionan datos bastante precisos, pero no tienen la precisión necesaria para permitir un posicionamiento altamente realista de objetos virtuales frente a una escena del mundo real. Además de la falta de precisión, cada sensor tenía debilidades que podrían permitirles proporcionar datos falsos en algunas circunstancias. Nuestro objetivo es utilizar el sistema de visión estéreo para proporcionar una mejor capacidad de rastrear la posición del casco, midiendo el cambio en las imágenes de video a medida que se mueve el casco, luego combinar los datos de seguimiento de visión estéreo con los otros datos del sensor para obtener la mejor estimación posible de la posición del casco.

Un ser humano que mira una imagen de video puede determinar intuitivamente el movimiento de la cámara de video a partir de la forma en que se mueven las imágenes de video. Por ejemplo, si la cámara gira hacia la derecha, esperamos que los objetos en la imagen de video se muevan hacia la izquierda. Si la cámara se mueve hacia adelante, los objetos en el centro de la imagen se agrandarán y los objetos en la parte superior, inferior o laterales de la imagen se alejarán del centro y se acercarán al borde de la imagen. Si ponemos la cámara boca abajo, la imagen también girará boca abajo. Si usamos un programa de computadora para rastrear puntos en una secuencia de imágenes de video, y usamos visión estéreo para calcular la posición 3D de estos puntos con respecto a la cámara en movimiento, entonces podemos usar la información de rastreo de puntos para calcular el movimiento de la cámara, tal como lo hace un humano intuitivamente. Si podemos seguir estos puntos de seguimiento y determinar su posición con un alto nivel de precisión y exactitud, entonces también podemos rastrear la posición del casco con un nivel más alto de precisión y exactitud de lo que es posible con nuestro sensor de inercia o nuestro sensor de posición inalámbrico. .

Para rastrear la posición de un punto con respecto a una cámara en movimiento, necesitamos usar un par de cámaras estéreo y seguir el punto en las imágenes de ambas cámaras. Primero necesitamos hacer coincidir el punto entre las imágenes izquierda y derecha, para poder determinar la posición del punto, luego necesitamos seguir ese punto a través de una secuencia de imágenes de ambas cámaras, para poder determinar el movimiento del punto. En general, no es fácil para un programa de computadora encontrar puntos coincidentes en un par de imágenes, pero algunos puntos son más fáciles de rastrear que otros. Para desarrollar el mejor algoritmo de seguimiento de puntos, necesitamos una forma de identificar puntos que sean fáciles de rastrear, y necesitamos una forma de eliminar las coincidencias falsas tanto como sea posible, mientras seguimos los puntos buenos el mayor tiempo posible.

Emparejamos puntos comparando el área alrededor de un punto en cada imagen y calculando su similitud. Si el área alrededor de un punto en una imagen es casi idéntica al área alrededor del punto de la otra imagen, entonces podemos concluir que los puntos coinciden. Si queremos asegurarnos de que solo usamos las mejores coincidencias para el seguimiento de puntos, solo podemos aceptar coincidencias que tengan las mejores puntuaciones de similitud. Sin embargo, este enfoque no nos da la capacidad de rastrear puntos a través de una secuencia larga de imágenes a medida que la cámara se mueve, y no nos da una buena capacidad para reconocer puntos que ya rastreamos anteriormente. A medida que la cámara se mueve, cambia la apariencia de un punto de seguimiento. El área alrededor de un punto puede agrandarse a medida que la cámara se mueve hacia él, o el área alrededor de un punto puede girar cuando se gira la cámara. Los algoritmos de coincidencia de puntos simples no pueden tener en cuenta este tipo de cambios, por lo que muestran una puntuación de similitud más baja, lo que hará que el punto sea rechazado. Necesitamos una forma de reconocer un punto que hemos estado rastreando incluso si lo vemos desde un ángulo diferente, de modo que podamos rastrear buenos puntos mientras permanezcan a la vista, y reconocer puntos rastreados previamente si vuelven a estar a la vista. Si podemos lograr este nivel de seguimiento de puntos a largo plazo, entonces podremos seguir la posición del casco DARTS con precisión durante períodos de tiempo prolongados. Nuestro objetivo es combinar una variedad de técnicas avanzadas de procesamiento de imágenes para lograr este tipo de seguimiento de puntos.

Hemos desarrollado varios programas de prueba que nos mueven hacia este objetivo. El primer paso es reconocer puntos cuando se ven desde diferentes ángulos. Por ejemplo, si comenzamos a rastrear un punto y lo rastreamos a través de una secuencia en movimiento de 100 imágenes, queremos poder comparar el punto de la última imagen y ver que todavía coincide con el punto de la primera imagen. Una técnica de procesamiento de imágenes llamada transformación afín puede modelar el cambio en la apariencia de un punto cuando se ve desde diferentes ángulos. Si podemos encontrar una transformación afín que cambie el punto de partida para que aparezca como lo haría desde el ángulo de visión final, entonces los puntos deberían tener el mismo aspecto. Cuando calculamos la similitud entre el punto inicial transformado y el punto final, deberíamos poder obtener una puntuación de coincidencia muy buena, que no podríamos obtener sin aplicar la transformación afín. Hemos desarrollado un programa que aplica esta técnica y la utiliza para rastrear una serie de puntos a través de una secuencia de imágenes de una cámara.

Además de rastrear puntos a través de una secuencia de imágenes, también necesitamos hacer coincidir los puntos entre las cámaras izquierda y derecha. Esto nos permite determinar la distancia y el ángulo desde la cámara al punto. A medida que la cámara se mueve, esta distancia y ángulo cambiarán. Al medir el cambio en la distancia y el ángulo de varios puntos, podemos calcular el movimiento de la cámara. Hemos desarrollado un código que hace coincidir puntos entre una cámara izquierda y derecha, luego rastrea esos puntos de una imagen a la siguiente.

Combinaremos la funcionalidad del programa de seguimiento de posición con la funcionalidad del programa que compensa los cambios en el ángulo de visión. Una vez que combinemos estos programas, tendremos una buena capacidad inicial para rastrear puntos en varios fotogramas. El siguiente paso será desarrollar filtros Kalman que refinarán los datos ruidosos que recibimos del rastreador de posición inalámbrico, el rastreador de posición inercial y el sistema de rastreo de puntos. Cada lectura de cada fuente de datos tenderá a contener algún error, y cada fuente de datos estará ligeramente en desacuerdo con las otras fuentes de datos. Un filtro de Kalman es una técnica para combinar datos ruidosos de múltiples fuentes de datos para proporcionar una estimación óptima del valor que se mide. En nuestro caso, el filtro Kalman proporciona una estimación óptima de la posición y orientación del casco DARTS, con nuevas estimaciones actualizadas a medida que se toma cada nueva lectura del sensor. El sistema combinado, con seguimiento de puntos mejorado desde la visión estéreo y filtrado de Kalman para combinar y suavizar múltiples fuentes de datos, proporcionará una mejora significativa en el rendimiento del sistema DARTS.

Resumen de hallazgos del programa DARTS

Aquí resumimos los principales hallazgos de este esfuerzo:

Descubrimos que la RA desmontada y portátil se puede lograr

Pudimos sentir el entorno alrededor del usuario de AR para recopilar los datos necesarios para mostrar los objetos virtuales correctamente.

Demostramos la ocultación en tiempo real de objetos virtuales (virtuales y dinámicos) por objetos reales.

Pudimos mostrar un objeto virtual correctamente mientras el usuario se movía en posición y orientación alrededor del objeto virtual.

Pudimos acomodar las necesidades de procesamiento y energía del sistema en una configuración para uso personal.

El software eficiente puede permitir que AR funcione con éxito con requisitos de procesamiento reducidos para permitir el funcionamiento en tiempo real sin requisitos excesivos de equipo

Los datos de visión estéreo se pueden utilizar para recopilar los datos ambientales necesarios.

Las técnicas avanzadas de visión por computadora pueden proporcionar una mayor fidelidad a partir de los datos de visión estéreo

Es necesario mejorar el diseño de hardware para DARTS para aumentar la facilidad de uso del sistema.

DARTS podrá operar en sistemas informáticos portátiles como el Quantum 3D Thermite en un futuro próximo.

Las pantallas transparentes montadas en la cabeza, probablemente basadas en tecnología OLED, ofrecerán un nivel aceptable de visibilidad y detalle en un futuro próximo.

Una arquitectura de software reutilizable se puede adaptar y reutilizar con diferentes conjuntos de sensores según la clase de aplicación (arma, vehículo, sistema usado por el hombre)

Realidad aumentada en acción para el guerrero

Las siguientes imágenes son quizás la mejor manera de mostrar el potencial de AR para Warfighter:

Inyecte entidades virtuales en escenas en tiempo real del mundo real

Acomodar objetos del mundo real

Banco de pruebas de vehículos de combate de infantería (ICV)

Capacidad de RA sin ataduras y llevada por el hombre

Logros del programa DARTS

Nuestra demostración de DARTS, realizada en diciembre de 2005, fue un éxito. Pudimos demostrar un sistema AR usado por el hombre que permitía a un usuario de DARTS interactuar con un ICV virtual que se presentó en DARTS HMD. El usuario pudo ver el ICV virtual en el entorno real y en tiempo real desde diferentes puntos de vista. El usuario de DARTS también pudo ver el movimiento del ICV virtual en el entorno del mundo real y en tiempo real. Un resumen de los componentes que nos ayudaron a realizar este logro se resume aquí:

Interfaz DIS bidireccional:Desarrollamos software para recibir y decodificar unidades de datos de protocolo DIS (PDU) desde una conexión de red, y también para codificar y enviar DIS PDUs. Desarrollamos un código para convertir la posición y la orientación de la entidad entre el marco de coordenadas mundial utilizado por el banco de pruebas ICV a un marco de coordenadas local utilizado por DARTS.

Control de entidades virtuales:Integramos nuestro software de comunicación DIS PDU en DARTS para poder usar las coordenadas de posición y orientación de una PDU entrante para determinar la posición de un objeto virtual con respecto a la entidad DARTS. También desarrollamos un código para convertir la posición local de la entidad DARTS en coordenadas mundiales y enviar esas coordenadas en una PDU DIS saliente. Desarrollamos y demostramos una interfaz DIS inicial con el simulador ICV que permitía que las entidades virtuales y vivas interactuaran entre sí y permitía que un usuario desmontado viera una entidad virtual en una vista del mundo real y en tiempo real.

Seguimiento de posición inalámbrica:Desarrollamos un software para acceder al sistema de seguimiento de posición inalámbrico Ubisense y obtener actualizaciones de posición varias veces por segundo. Estos datos de posición se utilizan para permitir que el sistema DARTS determine dónde está en relación con el mundo, de modo que podamos determinar cómo se debe mostrar una entidad virtual en el sistema DARTS y cómo se debe mostrar el usuario de DARTS en el mundo virtual de muestra el banco de pruebas de ICV. Esta capacidad se utilizó para permitir demostraciones tempranas, a medida que desarrollamos nuestro seguimiento de puntos objetivos y algoritmos de recuperación de poses que no requerirán el uso de ninguna infraestructura adicional más allá del equipo que usa el soldado. Estos nuevos algoritmos de recuperación de pose eventualmente reemplazarán los datos de posicionamiento proporcionados por el sistema UbiSense (a medida que haya fondos disponibles para continuar con esta investigación). El sistema UbiSense también se utiliza para las pruebas del sistema DARTS para validar la precisión de nuestros algoritmos de recuperación de pose.

HMD basado en OLED:Integramos un HMD con base OLED monocular en el sistema para verificar la utilidad de las pantallas OLED para apoyar el entrenamiento desmontado. El HMD proporcionó una fidelidad adecuada en una pantalla monocular. Pudimos trabajar con fabricantes de HMD basados en OLED como Liteye e ICUITI para desarrollar un diseño conceptual para un sistema binocular. En este momento, la tecnología OLED presenta el mejor potencial para el desarrollo de soluciones HMD que sean suficientes para respaldar el entrenamiento desmontado y lo suficientemente económicas como para comprarlas en las grandes cantidades que serían necesarias si el Ejército de los EE. UU. adoptara esta tecnología de entrenamiento.

Sistema de transmisión de TV inalámbrico para soporte de demostración:Evaluamos varios sistemas de transmisión de imágenes e implementamos varios sistemas opcionales para que la vista producida para el usuario de DARTS esté disponible para otros observadores cercanos.

Desarrollo de algoritmos de seguimiento de puntos y recuperación de poses:Implementamos un algoritmo de seguimiento de puntos usando el entorno de software MATLAB que puede rastrear puntos a través de una serie de imágenes. Este algoritmo encuentra puntos de diferentes áreas de la imagen de video, utilizando un algoritmo que identifica puntos fáciles de rastrear. Una vez que el algoritmo identifica estos puntos fáciles de rastrear, busca una coincidencia para cada uno de estos puntos en imágenes sucesivas. Estos puntos se utilizan para determinar la posición y la orientación del usuario de DARTS en relación con los objetos del mundo real y las entidades virtuales del entorno. Teníamos la esperanza de integrar el algoritmo mejorado en esta fase, pero no pudimos hacerlo debido al nivel de esfuerzo que llevó crear el algoritmo. Sin embargo, pudimos demostrar y validar el algoritmo usando clips de video obtenidos del sitio de demostración de STTC. Los siguientes párrafos brindan una descripción general del algoritmo de seguimiento de poses desarrollado para este esfuerzo.

Para mostrar un objeto virtual de modo que se superponga al mundo real correctamente, necesitamos tener una estimación muy precisa de la dirección a la que apunta el casco. Necesitamos rastrear esto de momento a momento a medida que el usuario de DARTS se mueve, y hacerlo con la mayor precisión posible. Si la cabeza del usuario no se sigue con precisión a medida que se mueve, entonces el objeto virtual parecerá moverse contra el mundo real de una manera poco realista. Además, pueden acumularse pequeños errores de posición hasta que el sistema se pierde por completo. Por ejemplo, si un objeto virtual debe estar exactamente 10 metros al sur de la posición del usuario, ese objeto debe estar centrado en el campo de visión del usuario si este mira hacia el sur. Si el sistema pierde el rastro de la orientación del usuario, no podrá mostrar el objeto cuando el usuario mire en la dirección correcta. En su lugar, podría mostrar el objeto al este o al oeste. Incluso podría hacer que parezca que el objeto virtual está girando alrededor del usuario.

Para nuestro esfuerzo base usamos un sensor de posición inalámbrico y un sensor de posición inercial para rastrear la posición y orientación del casco DARTS. Estos sensores proporcionan datos bastante precisos, pero no tienen la precisión necesaria para permitir un posicionamiento muy realista de objetos virtuales en una escena del mundo real. Además de la falta de precisión, cada sensor tenía debilidades que podían permitirles proporcionar datos falsos en algunas circunstancias. Nuestro objetivo es utilizar el sistema de visión estéreo para proporcionar una mejor capacidad para rastrear la posición del casco, midiendo el cambio en las imágenes de video a medida que se mueve el casco, luego combinar los datos de seguimiento de visión estéreo con los otros datos del sensor para obtener la mejor estimación de la posición del casco que podamos.

Un ser humano que mira una imagen de video puede determinar intuitivamente el movimiento de la cámara de video a partir de la forma en que se mueven las imágenes de video. Por ejemplo, si la cámara gira hacia la derecha, esperamos que los objetos en la imagen de video se muevan hacia la izquierda. Si la cámara se mueve hacia adelante, los objetos en el centro de la imagen crecerán y los objetos en la parte superior, inferior o lateral de la imagen se alejarán del centro y se acercarán al borde de la imagen. Si ponemos la cámara al revés, la imagen también girará al revés. Si usamos un programa de computadora para rastrear puntos en una secuencia de imágenes de video y usamos visión estéreo para calcular la posición 3D de estos puntos con respecto a la cámara en movimiento, entonces podemos usar la información de seguimiento de puntos para calcular el movimiento de la cámara. tal como lo hace un humano intuitivamente. Si podemos seguir estos puntos de seguimiento y determinar su posición con un alto nivel de precisión y exactitud, entonces también podemos rastrear la posición del casco con un mayor nivel de precisión y exactitud del que es posible con nuestro sensor inercial o nuestro sensor de posición inalámbrico. .

Para rastrear la posición de un punto con respecto a una cámara en movimiento, necesitamos usar un par de cámaras estéreo y seguir el punto en las imágenes de ambas cámaras. Primero, debemos hacer coincidir el punto entre las imágenes izquierda y derecha, para que podamos determinar la posición del punto, luego, debemos seguir ese punto a través de una secuencia de imágenes de ambas cámaras, para que podamos determinar el movimiento del punto. En general, no es fácil para un programa de computadora encontrar puntos coincidentes en un par de imágenes, pero algunos puntos son más fáciles de rastrear que otros. Para desarrollar el mejor algoritmo de seguimiento de puntos, necesitamos una forma de identificar puntos que sean fáciles de rastrear, y necesitamos una forma de eliminar las coincidencias falsas tanto como sea posible, mientras seguimos los puntos buenos el mayor tiempo posible.

Emparejamos puntos comparando el área alrededor de un punto en cada imagen y calculando su similitud. Si el área alrededor de un punto en una imagen es casi idéntica al área alrededor del punto de la otra imagen, entonces podemos concluir que los puntos coinciden. Si queremos asegurarnos de que solo usamos las mejores coincidencias para el seguimiento de puntos, solo podemos aceptar coincidencias que tengan las mejores puntuaciones de similitud. Sin embargo, este enfoque no nos brinda la capacidad de rastrear puntos a través de una larga secuencia de imágenes a medida que la cámara se mueve, y no nos brinda una buena capacidad para reconocer puntos que ya rastreamos anteriormente. A medida que la cámara se mueve, cambia la apariencia de un punto de seguimiento. El área alrededor de un punto puede crecer a medida que la cámara se mueve hacia él, o el área alrededor de un punto puede girar a medida que gira la cámara. Los algoritmos de coincidencia de puntos simples no pueden tener en cuenta este tipo de cambios, por lo que muestran una puntuación de similitud más baja, lo que hará que el punto sea rechazado. Necesitamos una forma de reconocer un punto que hemos estado rastreando incluso si lo vemos desde un ángulo diferente, de modo que podamos rastrear buenos puntos siempre que permanezcan a la vista, y reconocer puntos previamente rastreados si vuelven a estar a la vista. Si podemos lograr este nivel de seguimiento de puntos a largo plazo, podremos seguir la posición del casco DARTS con precisión durante largos períodos de tiempo. Nuestro objetivo es combinar una variedad de técnicas avanzadas de procesamiento de imágenes para lograr este tipo de seguimiento de puntos.

Hemos desarrollado varios programas de prueba que nos llevan hacia este objetivo. El primer paso es reconocer los puntos cuando se ven desde diferentes ángulos. Por ejemplo, si comenzamos a rastrear un punto y lo rastreamos a través de una secuencia en movimiento de 100 imágenes, queremos poder comparar el punto de la última imagen y ver que aún coincide con el punto de la primera imagen. Una técnica de procesamiento de imágenes llamada transformación afín puede modelar el cambio en la apariencia de un punto cuando se ve desde diferentes ángulos. Si podemos encontrar una transformación afín que cambie el punto de inicio para que aparezca como lo haría desde el ángulo de visión final, entonces los puntos deberían tener el mismo aspecto. Cuando calculamos la similitud entre el punto inicial transformado y el punto final, deberíamos poder obtener una puntuación de coincidencia muy buena, que no podríamos obtener sin aplicar la transformación afín. Hemos desarrollado un programa que aplica esta técnica y la usa para rastrear una serie de puntos a través de una secuencia de imágenes de una cámara.

Además de rastrear puntos a través de una secuencia de imágenes, también necesitamos hacer coincidir los puntos entre las cámaras izquierda y derecha. Esto nos permite determinar la distancia y el ángulo desde la cámara hasta el punto. A medida que la cámara se mueve, esta distancia y ángulo cambiarán. Al medir el cambio en la distancia y el ángulo de varios puntos, podemos calcular el movimiento de la cámara. Hemos desarrollado un código que hace coincidir puntos entre una cámara izquierda y derecha, luego rastrea esos puntos de una imagen a la siguiente.

Combinaremos la funcionalidad del programa de seguimiento de posición con la funcionalidad del programa que compensa los cambios en el ángulo de visión. Una vez que combinemos estos programas, tendremos una buena capacidad inicial para rastrear puntos en varios fotogramas. El siguiente paso será desarrollar filtros Kalman que refinarán los datos ruidosos que recibimos del rastreador de posición inalámbrico, el rastreador de posición inercial y el sistema de seguimiento de puntos. Cada lectura de cada fuente de datos tenderá a contener algún error, y cada fuente de datos discrepará ligeramente con las otras fuentes de datos. Un filtro de Kalman es una técnica para combinar datos ruidosos de múltiples fuentes de datos para proporcionar una estimación óptima del valor que se mide. En nuestro caso, el filtro de Kalman proporciona una estimación óptima de la posición y orientación del casco DARTS, con nuevas estimaciones actualizadas a medida que se toma cada nueva lectura del sensor. El sistema combinado, con un seguimiento de puntos mejorado desde la visión estéreo y el filtrado de Kalman para combinar y suavizar múltiples fuentes de datos, proporcionará una mejora significativa en el rendimiento del sistema DARTS.

Resumen de los resultados del programa DARTS

Aquí resumimos los principales hallazgos de este esfuerzo:

-

Descubrimos que se puede lograr AR portátil y desmontado

-

Pudimos sentir el entorno alrededor del usuario AR para recopilar los datos necesarios para mostrar objetos virtuales correctamente

-

Demostramos la ocultación en tiempo real de objetos virtuales (virtuales y dinámicos) por objetos reales

-

Pudimos mostrar un objeto virtual correctamente mientras el usuario se movía en posición y orientación alrededor del objeto virtual

-

Pudimos acomodar las necesidades de procesamiento y energía del sistema en una configuración de uso personal

-

El software eficiente puede permitir que AR funcione correctamente con requisitos de procesamiento reducidos para permitir la operación en tiempo real sin requisitos de equipo excesivos

-

Los datos de visión estéreo se pueden utilizar para recopilar los datos ambientales necesarios.

-

Las técnicas avanzadas de visión por computadora pueden proporcionar una mayor fidelidad de los datos de visión estéreo

-

Es necesario mejorar el diseño del hardware para DARTS para aumentar la facilidad de uso del sistema

-

DARTS podrá operar en sistemas informáticos portátiles como Quantum 3D Thermite en un futuro próximo

-

Las pantallas transparentes montadas en la cabeza, probablemente basadas en tecnología OLED, ofrecerán un nivel aceptable de visibilidad y detalle en un futuro próximo

-

Una arquitectura de software reutilizable se puede adaptar y reutilizar con diferentes conjuntos de sensores según la clase de aplicación (arma, vehículo, sistema usado por el hombre)

Realidad aumentada en el trabajo para el guerrero

Las siguientes imágenes son quizás la mejor manera de mostrar el potencial de AR para el Warfighter:

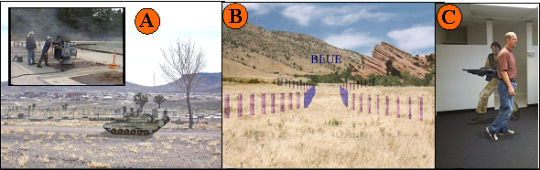

En las imágenes de arriba, artículo A muestra un tanque enemigo virtual incrustado en una escena del mundo real. Proporcionamos objetivos AR similares en nuestro sistema de artillería de objetivo virtual que admite armas, como la ametralladora Mark 38 (ver el recuadro del elemento A) con la capacidad de atacar objetivos dinámicos con fuego real o fuego seco.

Elemento B muestra el uso de AR para presentar gráficos de comando y control al usuario, integrados en su vista del mundo real en tiempo real. Esta infracción presentada por la mina se muestra a un conductor de plataforma militar a través de un sistema llamado Glass Turret Visualization System que fue desarrollado por nuestra empresa entre 2000 y 2003.

Elemento C presenta una vista de una fuerza virtual opuesta que está siendo ocluida dinámicamente por una persona que camina frente a la entidad virtual. Esta es una vista del sistema DARTS descrito en este documento.

Áreas que requieren un esfuerzo adicional

Al final de este esfuerzo, evaluamos el estado del sistema de demostración DARTS e identificamos varios elementos que deberían abordarse en la investigación futura de DARTS:

Integración de HMD binocular basado en OLED: ahora que hemos determinado que existen algunos sistemas HMD asequibles en el mercado que se pueden utilizar para admitir AR desmontado, nos gustaría integrar uno de estos en nuestro sistema DARTS.

Conjunto de sensores integrados para cascos: El esfuerzo de DARTS es un esfuerzo de investigación y desarrollo relativamente pequeño. Debido a esto, estamos haciendo todo lo posible para gastar los recursos del contrato solo en aquellos esfuerzos que mejoran el estado de la técnica en AR. Sin embargo, el estado actual del casco no es atractivo y es posible que deba perfeccionarse antes de que se utilice en una gran demostración pública.

Áreas que requieren investigación adicional

En nuestro esfuerzo básico, hemos identificado tres áreas que requerirán mejoras adicionales para lograr nuestro objetivo de un sistema AR creíble y usable. Estas áreas son:

Ocultación en tiempo real mejorada - En el esfuerzo de Base pudimos mejorar nuestra ocultación reemplazando nuestro sistema de cámara de escaneo con un sistema de cámara que captura una imagen completa en un solo instante. Esto nos permite eliminar lo que llamaremos el "efecto de tren" en nuestros datos de ocultación. Cuando las cámaras de exploración recogen una imagen mientras el usuario mueve la cabeza de un lado a otro, el movimiento de lado a lado hace que los píxeles de la parte inferior de la imagen se capturen más tarde que los de la parte superior de la imagen. Esta captura retrasada de píxeles puede causar que los objetos se distorsionen, de modo que la parte inferior del objeto parezca arrastrarse hacia un lado (la distorsión se parece a la cola de un vestido de novia u otro vestido muy formal; de ahí nuestro nombre para el efecto). El segundo efecto para corregir es el efecto de halo alrededor de los objetos. Esto se debe a que las limitaciones de la CPU no nos permiten muestrear cada píxel en un par de imágenes. Hemos desarrollado un algoritmo para reducir en gran medida (con suerte eliminar) este efecto que llamamos el "enfoque de ventanas deformables". Esto se describe brevemente en la siguiente sección.

Procesamiento paralelo distribuido - Integre la investigación sobre el procesamiento paralelo en unidades de procesamiento gráfico (GPU) para optimizar el uso de la CPU y minimizar los requisitos de hardware.

Seguimiento de posición mejorado / recuperación de pose - Reducir o eliminar la dependencia del posicionamiento inalámbrico. Integre el algoritmo de seguimiento de puntos mejorado desarrollado en esta fase en el sistema de demostración.

Ventanas deformables para una mejor ocultación

Con la estereovisión, encontramos la distancia a un punto encontrando ese punto en dos imágenes una al lado de la otra y midiendo el desplazamiento del punto de una imagen a la siguiente. Para encontrar qué píxel de la imagen de la derecha coincide con un píxel de la imagen de la izquierda, tomamos una ventana de píxeles alrededor del punto de la imagen de la izquierda y comparamos los valores de píxeles en esa ventana con las ventanas alrededor de un conjunto de píxeles de la imagen de la derecha. Elegimos el píxel de la imagen de la derecha cuya ventana coincide mejor con la ventana alrededor del píxel de la imagen de la izquierda. Para que esta técnica funcione bien, las ventanas alrededor de cada píxel deben tener una buena textura y deben cubrir un área que tenga la misma profundidad en toda la ventana. Cuando una ventana se extiende sobre un área de una imagen con dos profundidades diferentes, tiende a producir un resultado vago, lo que dificulta que el programa de estereovisión determine la profundidad correctamente. Debido a este problema, la mayoría de los sistemas de estereovisión no localizan correctamente los bordes entre un objeto cercano y su fondo.

Un enfoque que han probado recientemente los investigadores de estereovisión es utilizar ventanas de coincidencia deformables. Es habitual utilizar ventanas de coincidencia que estén centradas en los píxeles que se comparan, pero es igualmente válido en teoría utilizar ventanas que no estén centradas en sus píxeles. Las imágenes a continuación demuestran este concepto. Comenzamos con un par de imágenes del estacionamiento de UCF-IST. Observe el camión blanco en primer plano. Su posición se cambia entre la imagen de la izquierda y la derecha. Podemos encontrar la distancia al camión haciendo coincidir puntos entre las imágenes. Sin embargo, si miramos las ventanas seleccionadas en la parte trasera del camión, podemos ver que la mitad de cada ventana está sobre el camión y la otra mitad está sobre un área de fondo más distante. Los puntos seleccionados en el centro de cada ventana son en realidad parte del fondo y no parte del camión, por lo que un sistema de estereovisión debería determinar que este punto está más lejos que el camión. Sin embargo, un sistema de estereovisión que utilice ventanas de comparación como esta probablemente calcularía que este punto está a la misma distancia que el camión.

Si usamos un sistema de visión estéreo típico en este par de imágenes, probablemente encontraría la distancia correcta al camión, pero también crearía un halo de distancia falso alrededor del camión. En este halo de distancia falsa, se informaría falsamente que los píxeles de fondo más distantes tienen la misma distancia que el camión menos distante. Este halo tendrá de la mitad a dos tercios del ancho de nuestra ventana de comparación. Podemos intentar usar una ventana de comparación más pequeña para reducir este efecto, pero esto provoca más coincidencias falsas porque una ventana pequeña no puede capturar tanta textura de imagen. Una mejor solución es usar ventanas que no se extiendan por un límite de distancia. En las imágenes a continuación, estamos comparando ventanas alrededor del mismo punto que antes, pero ahora las ventanas están desplazadas hacia un lado, de modo que cubren principalmente el fondo. Es más probable que ventanas como esta determinen que este punto es parte del fondo y no del camión.

Para aplicar este enfoque en un sistema de estereovisión, necesitamos tener una forma de determinar cuándo un punto está cerca de un borde donde las distancias cambian repentinamente, y necesitamos poder determinar de qué manera mover la ventana para que cubra un borde. área que se encuentra principalmente en el fondo o principalmente en el objeto más cercano. Comenzaremos comparando todos los píxeles de la imagen utilizando el enfoque estándar, que compara las ventanas centradas en los píxeles que se comparan. Luego, el programa buscará en la imagen áreas en las que la distancia cambie repentinamente. En este punto asumiremos que no hemos encontrado el borde verdadero donde cambia la distancia y nos acercaremos a ese borde desde cualquier lado con ventanas desplazadas. Deberíamos poder encontrar una distancia correcta para muchos píxeles que anteriormente tuvieron resultados falsos. No podremos eliminar coincidencias falsas a lo largo de los bordes con este enfoque, pero es de esperar que podamos hacer una mejora significativa.

Los investigadores de la visión por computadora han probado una serie de técnicas como esta durante los últimos 20 años para intentar mejorar la calidad de los resultados de la estereovisión. En la mayoría de los casos, han podido mostrar algún beneficio, pero con frecuencia han encontrado que el costo de computación es muy alto. A medida que las computadoras se vuelven cada vez más rápidas, estamos llegando a un punto en el que es posible utilizar varios pasos de refinamiento para corregir los errores que surgen con varios tipos de imágenes. Este enfoque que utiliza ventanas deformables es uno de los varios que planeamos evaluar. Esperamos combinar varios de los enfoques más prometedores para lograr un alto nivel de precisión y solidez general.

Lecciones aprendidas del programa DARTS

Aquí presentamos las lecciones que aprendimos en el transcurso de este esfuerzo de investigación.

Descubrimos que nuestro conjunto de sensores, que incluye el sensor de posición inalámbrico, el sensor de posición inercial y las cámaras de visión estéreo, puede proporcionarnos los datos sin procesar que necesitamos para lograr una AR eficaz. Nuestro software podrá funcionar con éxito sin la necesidad de ninguna otra entrada de sensor.

Descubrimos que agregar la capacidad de moverse con el sistema DARTS y la capacidad de conectarse a otros simuladores usando una interfaz DIS agregó una complejidad significativa, lo que requirió un extenso esfuerzo de prueba de integración.

Descubrimos que necesitábamos estar al tanto de las definiciones únicas del sistema de coordenadas. Nuestro sistema central DARTS tiene un sistema de coordenadas interno, de modo que la posición de los objetos virtuales se puede relacionar con la posición del usuario DARTS. A medida que agregamos varias características y capacidades al sistema, encontramos una variedad de definiciones únicas de sistemas de coordenadas, que requerían conversiones de coordenadas para lograr la compatibilidad. Estas conversiones de coordenadas son muy difíciles de visualizar basándose únicamente en fórmulas matemáticas, por lo que no podíamos estar seguros de que nuestra conversión fuera correcta hasta que pudiéramos probar la salida visual del sistema DARTS para confirmar que los objetos virtuales se mostraban y se movían como se esperaba. Una de las tareas clave que tuvimos que realizar para integrar el sistema DARTS con el ICV para nuestra demostración en STTC fue probar visualmente la apariencia de nuestra entidad DARTS en las pantallas del ICV y ajustar los parámetros de conversión hasta que la entidad virtual se moviera del mismo. en la pantalla mientras el usuario de DARTS se movía en realidad.

Descubrimos que la credibilidad de un objeto virtual en AR se ve fuertemente afectada por la calidad de los modelos 3D utilizados. Es importante usar modelos altamente detallados para objetos virtuales y agregar señales visuales realistas como luces y sombras para hacer que el objeto virtual se vea más como si existiera en alguna posición en el espacio real. Los modelos que se utilizan para simulaciones típicas tienden a tener un nivel de detalle bajo. Estos modelos son lo suficientemente buenos en un entorno de simulación, porque generalmente aparecen muy lejos en la pantalla y porque toda la simulación tiene una apariencia artificial. Sin embargo, cuando los objetos virtuales se ven en una escena real, necesitan un mayor realismo para lograr una buena credibilidad.

Los requisitos de energía deben incluir hardware para soporte de demostración por adelantado. En nuestro proceso de desarrollo, inicialmente necesitábamos energía para nuestra computadora portátil, cámaras de video y sensor de posición inercial. A medida que agregamos componentes adicionales para permitirnos transmitir una imagen de salida con fines de demostración, nos vimos obligados a suministrar múltiples voltajes, utilizando múltiples paquetes de baterías. Para acomodar todos los componentes y el cableado, pasamos por varias configuraciones a medida que cambiamos varias características. Determinamos que debemos planificar todos los requisitos de nuestro sistema desde el principio al realizar más cambios en el sistema.

El hardware debe estar reforzado para admitir el desarrollo. Tuvimos una serie de problemas durante el desarrollo del sistema debido a componentes delicados y delicados que funcionaron bien en un banco de pruebas, pero funcionaron mal cuando se usó el sistema en una configuración móvil portátil. Descubrimos que es necesario trabajar con los proveedores de componentes para encontrar componentes resistentes y luego asegurarnos de que nuestros arreglos de montaje y cableado permitieran la máxima estabilidad durante la operación móvil.

La operación temprana de principio a fin es una necesidad para impulsar el desarrollo. Nuestro proceso de desarrollo requirió que logremos varias capacidades discretas, como una interfaz DIS o la integración de nuestro sistema de posicionamiento inalámbrico. No pudimos realizar pruebas móviles completas de un extremo a otro hasta que se implementaron todas estas funciones o subsistemas. Descubrimos que aunque todos nuestros subsistemas funcionaban por separado, y aunque el sistema funcionaba bien en el banco de pruebas, había dificultades imprevistas con el funcionamiento del sistema en una configuración móvil usada por el hombre. Determinamos que es importante lograr que un sistema de un extremo a otro funcione lo más rápido posible, para permitir que se descubran y solucionen problemas inesperados.

Descubrimos que nuestro sistema de posicionamiento inalámbrico es capaz de proporcionar datos de posición con una tasa de error relativamente pequeña, pero cuando probamos el sistema DARTS completo al aire libre en una configuración móvil, hubo frecuentes interrupciones de la señal inalámbrica utilizada para determinar la posición. Llegamos a la conclusión de que es probable que las interrupciones de señal como esta sean comunes en un escenario de entrenamiento típico de DARTS, por lo que trabajaremos para minimizar nuestra dependencia de los datos de posicionamiento externos. A lo sumo, esperamos utilizar estos datos como un punto de referencia ocasional para asegurar que nuestra estimación continua de la posición siga siendo precisa.

Acomodar el movimiento libre es alcanzable pero difícil. Descubrimos que operar el sistema en el banco de pruebas era mucho más fácil que operar el sistema en una configuración móvil usada por el hombre. Los componentes y las conexiones de cableado que funcionaron bien en el banco de pruebas tendían a hacer que nuestra computadora se congelara cuando intentábamos usar el sistema. Tuvimos que reemplazar, volver a montar o volver a cablear componentes para mejorar su estabilidad. También descubrimos que los datos de los sensores son más ambiguos cuando se mueven, lo que nos obligó a ajustar cuidadosamente nuestro software para proporcionar resultados aceptables. Uno de los principales objetivos de nuestro esfuerzo de seguimiento será permitir que el sistema compense los pequeños cambios en la configuración de los sensores sin reducciones en el rendimiento.

Beneficios potenciales de AR para el guerrero

Hemos identificado los siguientes usos de la RA para cumplir con los requisitos de entrenamiento militar:

OBJETIVOS - Las necesidades del guerrero exigen la creación de una nueva generación de objetivos a distancia. Esta nueva generación de objetivos debe representar un amplio espectro de plataformas / individuos amistosos, enemigos y neutrales para apoyar los preparativos necesarios para tener éxito en el complejo entorno operativo actual. Los objetivos deben poder reaccionar a las acciones del alumno y presentar comportamientos complejos creíbles. Además de todo esto, los objetivos futuros deben ser observables durante el funcionamiento de día, noche y en condiciones oscuras, así como ser observados por gafas de visión nocturna u otros sistemas de sensores. Claramente, AR es un candidato razonable para cumplir con estos requisitos futuros, ya que los objetivos AR se pueden usar para soportar ejercicios de fuego real, FTX y fuego seco sin la necesidad de una infraestructura de alcance extenso. Los objetivos AR pueden integrarse en los sistemas y equipos del Warfighter.

MANDO Y CONTROL y MEDIDAS DE CONTROL DE EJERCICIO - Los Centros de Entrenamiento de Combate (CTC) exigen que las unidades ejecuten operaciones complejas mientras están bajo la observación del personal de CTC. Con frecuencia, el personal de CTC debe insertarse rápidamente en el entorno de capacitación para garantizar que las unidades estén capacitadas de manera adecuada y segura. Estos mismos miembros del personal de CTC pueden ser enviados en cualquier momento para observar las operaciones de la unidad. El uso de AR para ayudar a controlar la realización de maniobras de entrenamiento complejas y garantizar la seguridad del entrenamiento es una aplicación de AR que debe mejorarse.

INTEROPERACIÓN EN VIVO / VIRTUAL / CONSTRUCTIVA INCONSÚTIL - Hoy en día, la mayoría de los ejercicios a gran escala ya no se realizan exclusivamente en rangos en vivo. Los ejercicios grandes suelen tener componentes de entrenamiento en vivo / virtuales y constructivos que se ejecutan simultáneamente. Una deficiencia notable de estos ejercicios combinados es la incapacidad de la fuerza de entrenamiento que opera en el componente en vivo del ejercicio para ver a sus contrapartes virtuales o constructivas. Esta falta de funcionamiento sin interrupciones se maneja hoy con la inserción de observadores / controladores o soluciones elaboradas que minimizan esta deficiencia. Proporcionar a las fuerzas que operan en el dominio Live con una visión de entidades virtuales y constructivas eliminaría la necesidad de estas soluciones poco realistas. Una solución de AR de este tipo también permitiría a los planificadores de ejercicios inyectar una fuerza de oposición más grande o componentes de fuerza amiga en los ejercicios para presentar un entrenamiento más desafiante.

RECONOCIMIENTO DEL SISTEMA - Las operaciones de hoy exigen que los combatientes puedan identificar rápidamente las fuerzas amigas, enemigas y neutrales en un momento. La RA podría usarse en los sitios de capacitación y mientras se está en el teatro de operaciones para perfeccionar las habilidades de reconocimiento del sistema para disminuir los tiempos del ciclo de decisión y reducir el potencial de fratricidio.

ANIMACIÓN DE REVISIÓN DESPUÉS DE LA ACCIÓN - Una vez que una unidad ha completado una maniobra, la RA podría usarse para permitir que los miembros de la unidad recorran su maniobra y examinen sus decisiones y acciones en puntos críticos. Estas animaciones de escena podrían usarse con unidades posteriores para mostrar cómo las unidades anteriores ejecutaron las maniobras. Este podría ser un valor particular en operaciones de unidades pequeñas asociadas con el combate urbano.

PRESENTACIÓN DE INFORMACIÓN DE SEGURIDAD - Siempre que se realicen ejercicios con fuego real, siempre existe la posibilidad de que alguien pueda resultar herido o muerto. La AR podría usarse para reforzar aún más los límites de alcance izquierdo y derecho, los límites de alcance, los rangos calientes y los rangos que se han cerrado temporalmente hasta que se resuelva un mal funcionamiento del arma u otro problema.

ENSAYO DE MISIÓN - La RA podría usarse para construir virtualmente elementos clave del terreno para las próximas operaciones. Esto permitiría a las unidades realizar ensayos de misión más realistas para mejorar sus posibilidades de éxito en la misión. La RA también se podría utilizar para presentar situaciones complejas del tipo "qué pasaría si" que podrían utilizarse para perfeccionar el plan final o ayudar a desarrollar contingencias en caso de que surjan problemas.

PRESENTACIÓN DE MANDO Y CONTROL OPERACIONAL - GRÁFICOS: en el pasado, usamos AR para presentar gráficos operativos en terreno real en tiempo real para mejorar el conocimiento de la situación. El uso de AR en este contexto asegura que los gráficos operativos se puedan cumplir en todas las condiciones climáticas y de luz. También reduce el tiempo necesario para tomar decisiones, ya que elimina el tiempo que se utiliza actualmente para asociar los gráficos operativos presentados en los mapas al integrarlos en la vista en tiempo real del mundo real del soldado.

NAVEGACIÓN PARA OPERACIONES Y ENTRENAMIENTO - Al igual que la descripción en la viñeta anterior, AR se puede utilizar para presentar información de navegación en tiempo real a los conductores de plataforma y soldados desmontados.

MARCADO DE OBSTÁCULOS VIRTUALES - Los teatros operativos de hoy están llenos de obstáculos y peligros que deben evitarse. A menudo, se pierden los marcadores que muestran los caminos a través o alrededor de estos obstáculos. Con frecuencia, las condiciones climáticas pueden hacer que estos marcadores sean imposibles de ver. El uso de AR para marcar los pasajes de obstáculos podría ayudar a salvar a los soldados al guiarlos de manera segura alrededor o a través de barreras y obstáculos.

ENTRENAMIENTO DEL OBSERVADOR AVANZADO - Una de las primeras aplicaciones para el entrenamiento militar que identificamos fue el uso de AR para el entrenamiento de Forward Observer. En esta aplicación, uno podría inyectar objetivos y fuerzas virtuales en la vista del observador delantero (a través de un bloque de visión, mira de arma, binocular u otro dispositivo) y permitir que el Observador delantero determine si la entidad es un objetivo y, de ser así, la mejor forma de procesarlo. Tal sistema sería de gran utilidad para las unidades de artillería que rara vez ven el fruto de su trabajo. La Vista del Observador Avanzado como objetivo enjuiciado podría registrarse, o incluso transmitirse a la artillería para su posterior discusión en una Revisión posterior a la acción (AAR).

Conclusión

Cada día que pasa, la integración de LVC avanza sin un componente clave para la integración completa en los dominios de entrenamiento, una capacidad para que el jugador en vivo vea e interactúe dentro del espacio de batalla integrado de LVC. A medida que la tecnología continúa mejorando y avanzando, el liderazgo del Ejército debe reconocer el potencial para el uso de herramientas y técnicas de Realidad Aumentada y la capacidad de esta tecnología para complementar los sistemas de entrenamiento existentes y futuros.

Una hoja de ruta de tecnología aumentada que se publicará próximamente proporcionará liderazgo de capacitación y gestión de tecnología con opciones para implementar soluciones de realidad aumentada y mixta para los requisitos operativos y de capacitación actuales y futuros. Aunque los enfoques para las soluciones técnicas son amplios y variados, existen algunas posibles soluciones "listas para usar" que se pueden aprovechar muy rápidamente. Por ejemplo, con algún desarrollo adicional, el sistema DARTS podría prepararse para una demostración que se sincronice con un experimento de capacitación próximo o planificado. Utilizado posiblemente en el papel de un observador avanzado, el sistema DARTS proporcionaría liderazgo de capacitación con exposición a la realidad aumentada en un entorno relevante. Además, los soldados tendrían la oportunidad de adquirir experiencia práctica, lo que generaría comentarios valiosos y otras aportaciones para el desarrollo futuro.

El camino a seguir

Asesorar a las comunidades de capacitación y prueba y al liderazgo sobre las capacidades y el potencial de la realidad aumentada.

Busque la ayuda y el respaldo de las partes interesadas.

Incluir la investigación de AR en los temas futuros de los Objetivos de Tecnología del Ejército (ATO) y la Investigación de Innovación de Pequeñas Empresas (SBIR); y continuar el desarrollo bajo múltiples ATO.

Demostrar tecnología útil a líderes y generadores de requisitos.

Planifique y transforme las capacidades de realidad aumentada en programas de adquisición existentes y planificados.

Sobre los autores

Frank Dean Actualmente es investigador principal y gerente de C&T en el Centro de Tecnología de Simulación y Capacitación (STTC), RDECOM, Orlando, Florida. El Sr. Dean gestiona proyectos de I + D relacionados con la mejora del aprendizaje experiencial y la formación del Warfighter, mediante el uso de tecnologías de realidad aumentada y mixta. El Sr. Dean tiene más de veinte años de experiencia con varios programas de tecnología y adquisición de sistemas de armas militares. Antes de su asignación a RDECOM, el Sr. Dean dirigió proyectos de ingeniería para PEO Simulation, Training & Instrumentation (PEO STRI), incluidas las operaciones y el mantenimiento del National Training Center Instrumentation System (NTCIS), Ft. Irwin, California. Dean tiene una licenciatura en ingeniería eléctrica (BSEE) de la Universidad de Miami en 1982 y una maestría en administración de ingeniería (MEM) de la Universidad George Washington en 1994.

Sheila Jaszlics es la presidenta de Pathfinder Systems, Inc. y ha estado buscando AR para entrenamiento y operaciones militares desde 1991. Es coautora de una patente de EE. UU. que describe la inyección en tiempo real de entidades virtuales en escenas en tiempo real (patente de EE. UU. 6,166,744).

Scot Sanders es un graduado de la Universidad del Norte de Colorado. Ha estado con Pathfinder Systems, Inc. durante varios años y ha sido un desarrollador clave del software del sistema básico y las interfaces de hardware que se utilizan en todos los sistemas de RA de Pathfinder. Además, Scot es el creador del conjunto de sensores de elevación y azimut de alta fidelidad que se utilizan en todos los sistemas AR de Pathfinder que admiten fuego real para armas servidas por la tripulación. También es un desarrollador del software de filtro Kalman que se utiliza para extraer y suavizar los datos que recibimos de los conjuntos de sensores híbridos que usamos en todos nuestros sistemas.

Rick Stilson es un graduado de la Escuela de Minas de Colorado y es el autor de gran parte del software de recuperación de poses que se desarrolló bajo este esfuerzo. También fue responsable de gran parte del software del sistema DARTS y del hardware del sistema de seguimiento. Como empleado de Pathfinder Systems, proporciona experiencia en todas las áreas técnicas asociadas con los algoritmos de visión estéreo. Es el ingeniero a cargo de desarrollar el enfoque de “ventanas deformables” para la búsqueda de bordes que implementaremos para mejorar la calidad de nuestros datos de ocultación en tiempo real.